店铺同步客户:吉客云与金蝶云星空对接案例分析

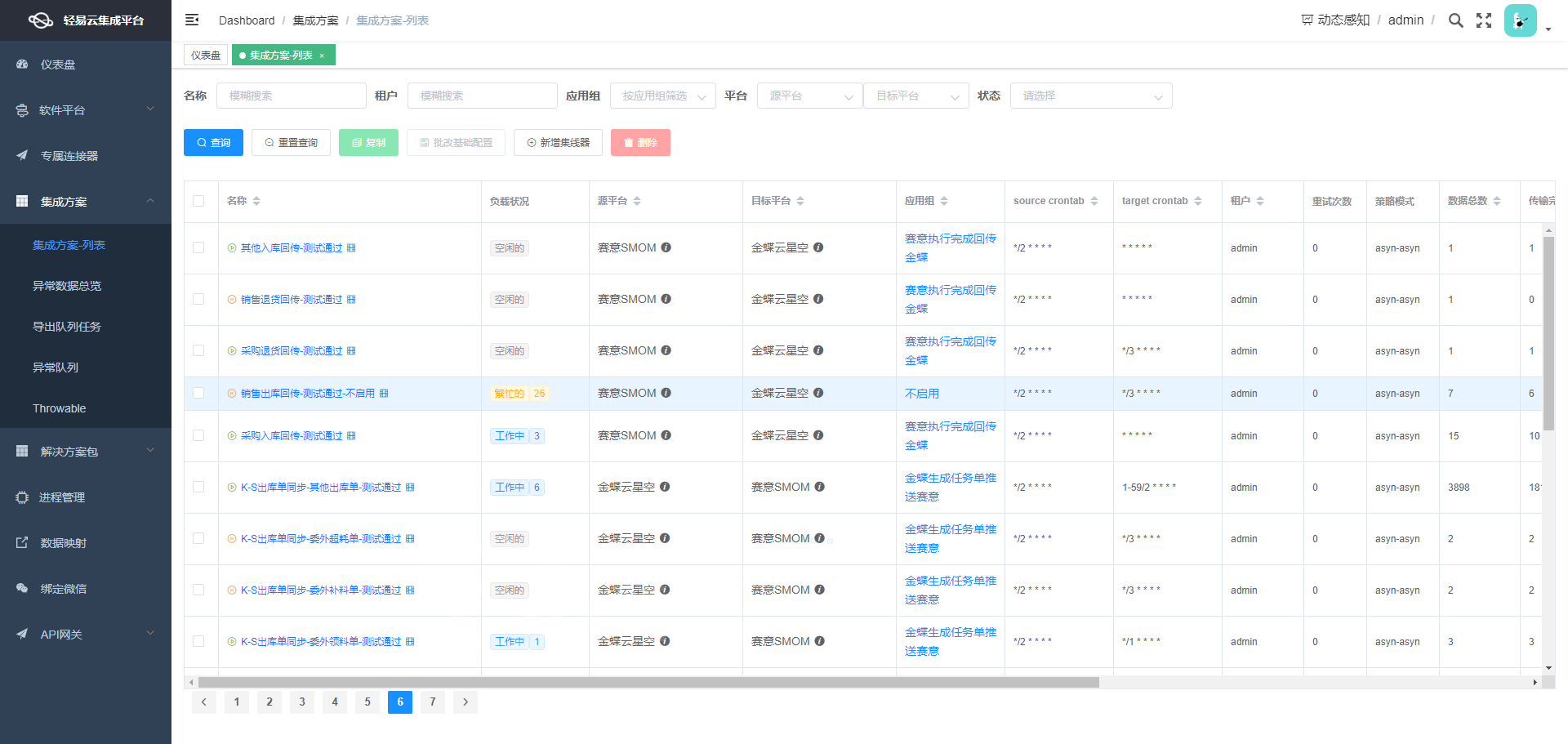

在本次技术分享中,我们聚焦于一个实际运行的系统对接集成方案——“店铺同步客户”,该方案旨在将吉客云中的数据高效且准确地集成到金蝶云星空之中。本文通过具体的API接口及其实现细节,探讨如何确保数据的不漏单以及高效处理大规模数据写入过程。

1. 数据源设置与获取

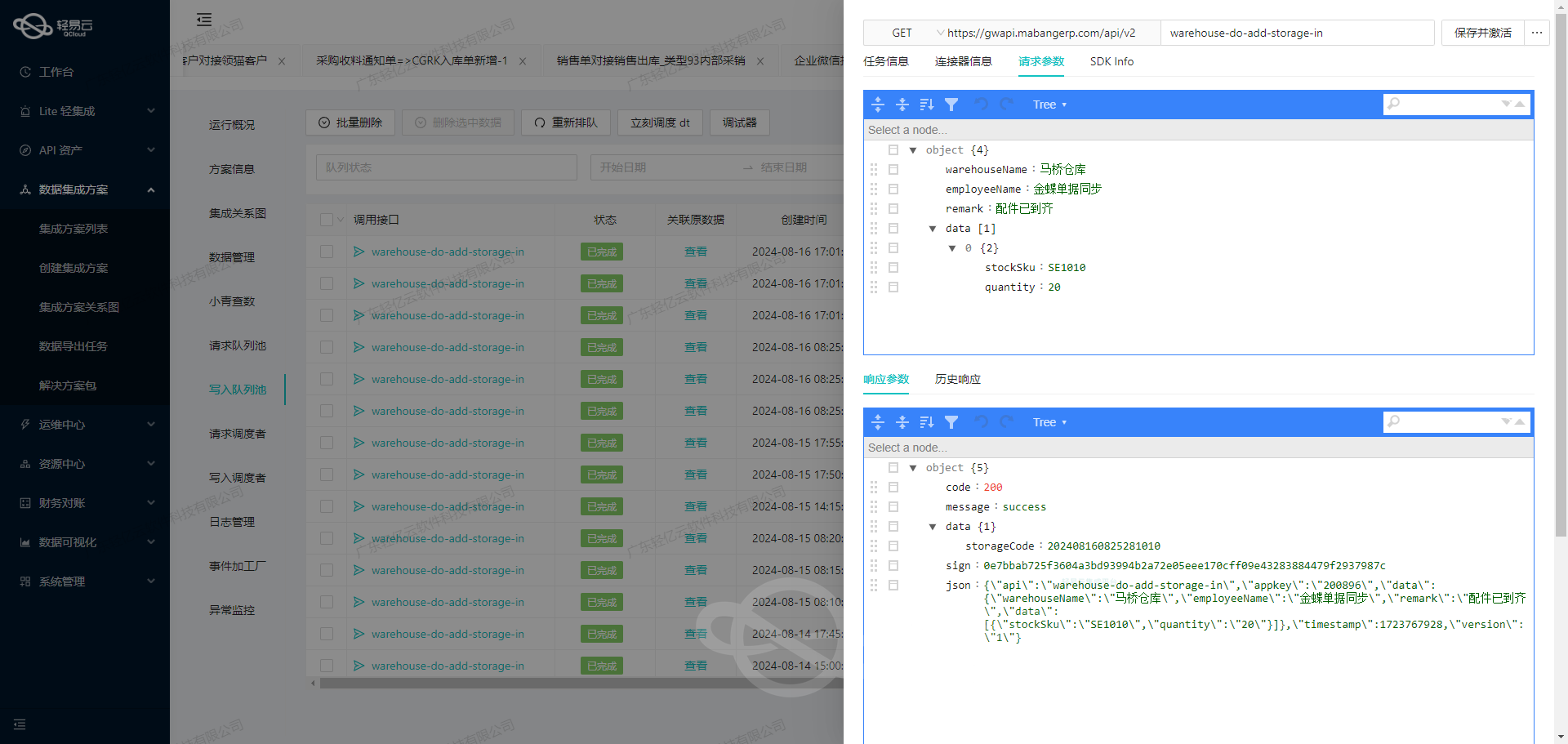

为确保从吉客云能够可靠地抓取并统一转换所需的数据,我们首先调用了erp.sales.get接口。这个步骤至关重要,因为它不仅决定了后续的数据流动路径,还需要考虑分页和限流的问题,以避免因大量请求导致系统压力过大或超时错误。这一步骤也涉及到实时监控与日志记录功能,为每一次API调用都生成详细的执行状态报告。

2. 数据处理与转换逻辑

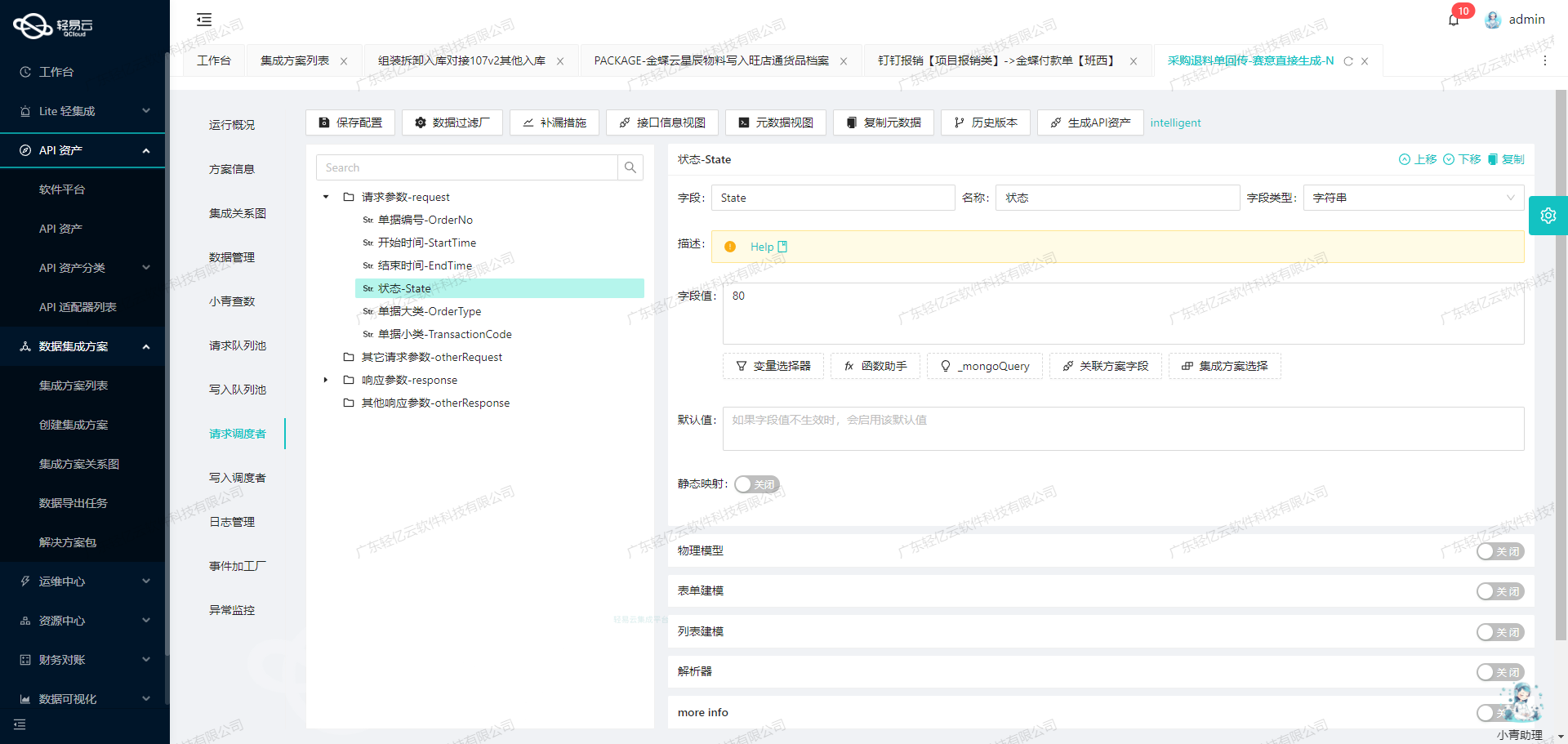

一旦我们获得了初步的数据提取结果,就要进行必要的格式转换以适应目标系统——金蝶云星空。此处,自定义数据转换逻辑发挥关键作用,通过可视化的数据流设计工具,我们能够直观地将源数据映射到目标字段,并根据特定业务需求调整和优化这些转换规则。例如,将不同字段名称或类型之间进行对应,从而最大程度降低人工干预。

3. 高吞吐量写入机制

对于存量较大的数据信息,如店铺信息、客户详情等,我们使用了金蝶云星空提供的批量保存API接口batchSave,以便快速完成海量数据导入。在这一过程中,高吞吐量的数据写入能力显得尤为重要,可以有效提升整体处理效率。此外,集中监控与告警系统会持续追踪任务状态,如发现异常及时启动重试机制,从而保证任务顺利完成。

接下来,文章将进一步深入探讨各个环节中的技术细节,包括如何应对可能出现的异常情况,以及针对不同类型数据所制定的一些优化策略。

调用吉客云接口erp.sales.get获取并加工数据

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用吉客云的erp.sales.get接口,并对获取的数据进行初步加工。

接口调用配置

首先,我们需要配置元数据,以便正确调用吉客云的API接口。以下是元数据配置的详细信息:

{

"api": "erp.sales.get",

"method": "POST",

"number": "channelCode",

"id": "channelCode",

"idCheck": true,

"condition_bk": [

[

{

"field": "companyCode",

"logic": "eq",

"value": "DSGL"

}

]

],

"request": [

{

"label": "页码",

"field": "pageIndex",

"type": "string"

},

{

"label": "页大小",

"field": "pageSize",

"type": "string",

"value": "50"

},

{

"label": "店铺编码",

"field": "code",

"type": "string"

},

{

"label": "店铺名称",

"field": "name",

"type": "string"

},

{

"label": "起始开始时间",

"field": "gmtModifiedStart",

"type": "string"

},

{

"label": "结束修改时间",

"field": "gmtModifiedEnd",

{

...请求参数设置

在实际操作中,我们需要根据业务需求设置请求参数。以下是几个关键参数及其含义:

pageIndex: 页码,用于分页请求。pageSize: 每页记录数,默认设置为50。code: 店铺编码,用于指定特定店铺的数据。name: 店铺名称,可用于模糊查询。gmtModifiedStart和gmtModifiedEnd: 起始和结束修改时间,用于筛选特定时间段内的数据。

例如,如果我们需要获取某个特定店铺在某个时间段内的销售数据,可以这样设置请求参数:

{

...

{

...

{"pageIndex":"1"},

{"pageSize":"50"},

{"code":"SHOP123"},

{"name":"Test Shop"},

{"gmtModifiedStart":"2023-01-01T00:00:00Z"},

{"gmtModifiedEnd":"2023-01-31T23:59:59Z"}

}

}数据清洗与转换

获取到原始数据后,下一步是进行数据清洗和转换。这一步骤非常关键,因为它直接影响到后续的数据处理和分析。

-

数据格式转换:将原始JSON格式的数据转换为目标系统所需的格式。例如,将日期格式从ISO8601转换为目标系统所需的格式。

-

字段映射:根据业务需求,将源系统中的字段映射到目标系统中的相应字段。例如,将

channelCode映射为目标系统中的storeId。 -

数据过滤:根据业务规则过滤不必要的数据。例如,只保留销售额大于某个值的记录。

以下是一个简单的数据清洗示例:

import json

from datetime import datetime

def clean_data(raw_data):

cleaned_data = []

for record in raw_data:

cleaned_record = {}

# 日期格式转换

cleaned_record['modifiedDate'] = datetime.strptime(record['gmtModified'], '%Y-%m-%dT%H:%M:%SZ').strftime('%Y-%m-%d %H:%M:%S')

# 字段映射

cleaned_record['storeId'] = record['channelCode']

# 数据过滤

if record['salesAmount'] > 1000:

cleaned_data.append(cleaned_record)

return cleaned_data

# 示例原始数据

raw_data = [

{"gmtModified":"2023-01-15T12:34:56Z",

...

}

]

cleaned_data = clean_data(raw_data)

print(json.dumps(cleaned_data, indent=2))实时监控与日志记录

为了确保数据集成过程的透明度和可靠性,实时监控和日志记录是必不可少的。通过轻易云平台提供的可视化界面,可以实时监控API调用状态、请求参数、响应结果等信息。此外,还可以设置告警机制,当出现异常情况时及时通知相关人员。

日志记录示例:

{

...

{

...

{"timestamp":"2023-01-15T12:34:56Z",

...

}

}通过以上步骤,我们可以高效地调用吉客云接口获取并加工数据,为后续的数据处理和分析打下坚实基础。在整个过程中,轻易云平台提供了全方位的支持,使得复杂的数据集成任务变得更加简便和高效。

使用轻易云数据集成平台将数据转换并写入金蝶云星空API接口

在数据集成的生命周期中,第二步至关重要,即将已经集成的源平台数据进行ETL(Extract, Transform, Load)转换,并最终写入目标平台。在本案例中,我们将探讨如何通过轻易云数据集成平台将店铺同步客户的数据转换为金蝶云星空API接口所能接收的格式,并写入目标平台。

数据转换与写入配置

为了实现这一目标,我们需要配置元数据,以确保数据能够正确地从源系统提取、转换并加载到金蝶云星空。以下是具体的元数据配置:

{

"api": "batchSave",

"method": "POST",

"idCheck": true,

"operation": {

"rowsKey": "array",

"rows": 20,

"method": "batchArraySave"

},

"request": [

{

"field": "FName",

"label": "客户名称",

"type": "string",

"value": "{channelName}"

},

{

"field": "FNumber",

"label": "客户编码",

"type": "string",

"value": "{channelCode}"

},

{

"field": "FCreateOrgId",

"label": "创建组织",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params": "FNumber"

},

"value": "100"

},

{

"field": "FUseOrgId",

"label": "使用组织",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params":"FNumber"

},

value: “100”

}

],

“otherRequest”: [

{

“field”: “FormId”,

“label”: “业务对象表单Id”,

“type”: “string”,

“describe”: “必须填写金蝶的表单ID如:PUR_PurchaseOrder”,

“value”: “BD_Customer”

},

{

“field”: “Operation”,

“label”: “执行的操作”,

“type”: “string”,

value: “BatchSave”

},

{

field: IsAutoSubmitAndAudit,

label: 提交并审核,

type: bool,

value: true

},

{

field: IsVerifyBaseDataField,

label: 验证基础资料,

type: bool,

describe: 是否验证所有的基础资料有效性,布尔类,默认false(非必录),

value: false

}

]

}配置解析

-

API和方法:

api: 设置为batchSave,表示我们使用的是批量保存操作。method: 设置为POST,表示我们通过HTTP POST方法进行数据提交。

-

操作设置:

idCheck: 设置为true,表示在批量保存时进行ID检查。operation: 包含了具体的操作细节,如rowsKey设置为array表示数据以数组形式提交,rows设置为20表示每次提交20条记录,method设置为batchArraySave表示使用批量数组保存方法。

-

请求字段映射:

FName: 映射到源系统中的客户名称字段{channelName}。FNumber: 映射到源系统中的客户编码字段{channelCode}。FCreateOrgId: 固定值100,通过解析器ConvertObjectParser转换为目标格式。FUseOrgId: 同样固定值100,并通过解析器ConvertObjectParser转换。

-

其他请求参数:

FormId: 固定值BD_Customer, 表示业务对象表单ID。Operation: 固定值BatchSave, 表示执行批量保存操作。IsAutoSubmitAndAudit: 设置为true, 表示自动提交并审核。IsVerifyBaseDataField: 设置为false, 表示不验证基础资料有效性。

实际应用案例

在实际应用中,我们首先需要确保源系统的数据已经成功提取并清洗。然后,通过上述配置,将这些清洗后的数据按照金蝶云星空API接口要求进行转换。以下是一个具体的应用步骤:

- 提取和清洗数据:从源系统中提取店铺客户信息,并进行必要的数据清洗和预处理。

- 配置ETL转换规则:根据上述元数据配置,将清洗后的数据字段映射到目标平台所需的字段格式。

- 调用API接口:使用HTTP POST方法调用金蝶云星空的批量保存接口,将转换后的数据提交到目标平台。

通过这种方式,我们可以实现不同系统间的数据无缝对接,确保数据在多个异构系统之间流动顺畅,提高业务效率和透明度。